L’IA connaît des progrès remarquables

Au cours des dernières décennies, l’intelligence artificielle connaît une expansion remarquable dans de nombreux champs d’application :

- reconnaissance d’images,

- traitement de la parole (Siri, Alexa, Sounhound)

- Langue naturelle (traduction, synthèse, résumés, Q&A, …)

- Jeux (dames, échecs, bricks, go, poker, starcraft,…)

- Aide à la décision (banque, finance, santé,…)

- Recommandations, publicités personnalisées,..

- Science (AlphaFold, astrophysique,…)

Cependant, avec l’avènement de l’IA générative, des failles apparaissent à mesure que les progrès accélèrent. Bertrand Braunschweig résume ainsi “cinq murs de l’IA” – les facteurs sur lesquels l’IA a des impacts – notamment dans la confiance, l’énergie, la sécurité, les interactions humain-machine, l’inhumanité. En outre, les grands modèles de langage (LLM) qui reposent en grande partie sur du deep learning, tels que ChatGPT, peuvent être source d’erreurs et générer :

- De la toxicité

- Des biais de stéréotype, équité

- Des manques liés à la robustesse vis-à-vis des attaques adverses / OOD

- Le non-respect de la vie privée

- Des problèmes éthiques

- Des hallucinations (inventions)

- Un non alignement avec les décisions des utilisateurs

Vers une IA de confiance

Le projet de réglementation européenne de l’intelligence artificielle, actuellement en cours de négociation, propose que des systèmes d’IA soient analysés et classés en fonction du risque qu’ils présentent pour les utilisateurs.

“Le sujet de la confiance est le sujet principal dans la réglementation européenne”, souligne Bertrand Braunschweig.

Les principes posés par l’Union européenne visent ainsi à veiller à ce que les systèmes d’IA utilisés dans l’UE soient sûrs, transparents, traçables, non discriminatoires et respectueux de l’environnement. En outre, pour qu’un système d’IA soit dit responsable et de confiance, il est nécessaire de prendre en compte ces trois dimensions, rappelle l’expert :

- La dimension technologique, englobant la robustesse et la fiabilité des systèmes.

- Les interactions avec les individus, incluant des aspects tels que l’explicabilité, la surveillance, la responsabilité et la transparence.

- La dimension sociale, abordant les enjeux liés à la vie privée et à l’équité.

Le Parlement européen, définit les systèmes d’intelligence artificielle comme étant un “système informatique qui est conçu pour fonctionner avec différents niveaux d’autonomie et qui peut, pour des objectifs explicites ou implicites, générer des résultats tels que des prédictions, des recommandations ou des décisions qui influencent des environnements physiques ou virtuels.

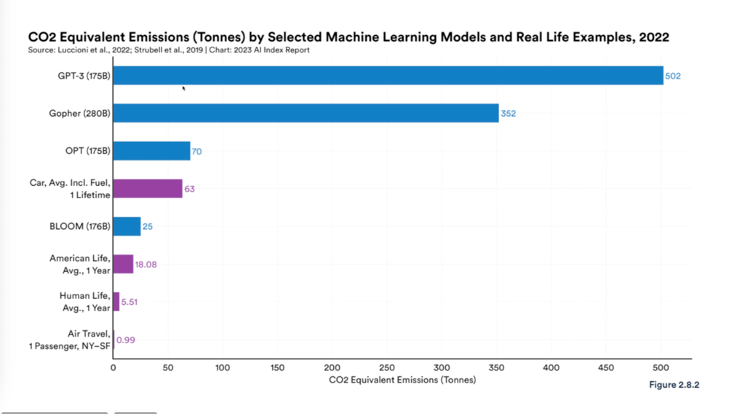

Les taux d’émissions carbone générés par ChatGPT3

Après avoir exposé les progrès technologiques et les enjeux de responsabilité de l’IA, Bertrand Braunschweig a examiné les défis actuels et futurs auxquels l’intelligence artificielle est confrontée. Ces défis comprennent le respect des données personnelles, la responsabilité de l’IA, ainsi que l’impact environnemental et énergétique associé au développement de ces outils. Ainsi sur le dernier point, on estime que les systèmes d’intelligence artificielle constituent des émetteurs significatifs de dioxyde de carbone. À titre d’exemples, GPT-3 a généré environ 500 tonnes d’émissions de CO2 en 2022. Des enjeux qui soulignent l’importance cruciale de fournir des solutions appropriées.

La Positive AI Community, une communauté d’échanges pour les membres de l’association

Cet événement – à l’image de ceux prochainement organisés – s’inscrit dans la lignée desengagements de l’association, qui visent à créer un espace d’échange et de partage de bonnes pratiques. La Positive AI Community a pour but de devenir la communauté de référence sur tous les sujets d’IA éthique pour progresser collectivement sur l’application de d’intelligence artificielle responsable au sein des organisations.

Vous souhaitez rejoindre l’initiative Positive AI et bénéficier des prochains événements de la Positive AI Community ? Rejoignez-nous